Aktualisiert am 19. Juni 2024

Dieser Artikel ist gehört zu der SEO-Checkliste für das SEO-Audit →

Wenn du eine Website betreibst, musst du unbedingt sicherstellen, dass die Suchmaschinen sie crawlen und indizieren können. Schließlich willst du ja, dass potenzielle Kunden dich online finden, oder? Hier sind ein paar Dinge, die du auf deiner SEO-Checkliste abhaken solltest, um sicherzustellen, dass die Suchmaschinen genau das tun können.

Sind deine Seiten indexiert?

Überprüfe, ob deine Website für Crawler zugänglich ist. Suchmaschinen müssen Zugang zu allen Seiten deiner Website haben, um sie zu indizieren.

Deine Website wird manchmal ohne dein Zutun von Suchmaschinen aufgenommen oder auch nicht. Auch die Fehlermeldungen sind je nach verwendetem SEO-Tool unterschiedlich. Macht nichts, analysieren und sammeln und sich um das einfach zu erledigende kümmern.

Tools zeigen unterschiedliche Ergebnissse

Warum ist das so? Tools zählen auch nur 1 und 2 zusammen und denken nicht selber, sie geben Prognosen. Und die Google Search Console ist dafür bekannt, zu viele Indexierungsfehler anzuzeigen – deshalb lohnt es sich manchmal, eine Website mit verschiedenen Tools zu testen und sich dann zu entspannen.

John Mueller (Webmaster Trends Analyst Google) sagte dazu, er wäre vorsichtig, blind SEO-Tools zu folgen, denn: SEO Tools prognostizieren, was wohl Google machen würde. Diese Prognosen sind mal richtig, mal falsch. Feedback über die Findbarkeit einer Homepage (warum, wieso, was ist zu tun) ist immer gut, jedoch bist du als Mensch gefragt, welchen Hinweisen du folgst oder nicht. Schau dir hier ein Video von John Mueller an, wo er auf eine Frage wegen Doppelten Contents eingeht →

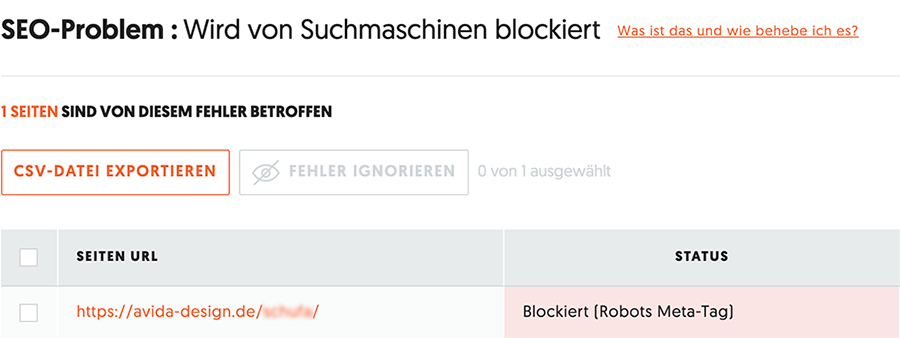

Ergebnis Ubersuggest

Du kannst kostenlos ein Projekt bei Ubersuggest anlegen →, das kann ich dir empfehlen – sehr gutes Tool! Ubersuggest hat die eine Datei gefunden, die ich absichtlich auf no-index gesetzt habe:

Lies hier weiter, was hinter diesem Meta-Tag no-index steckt →

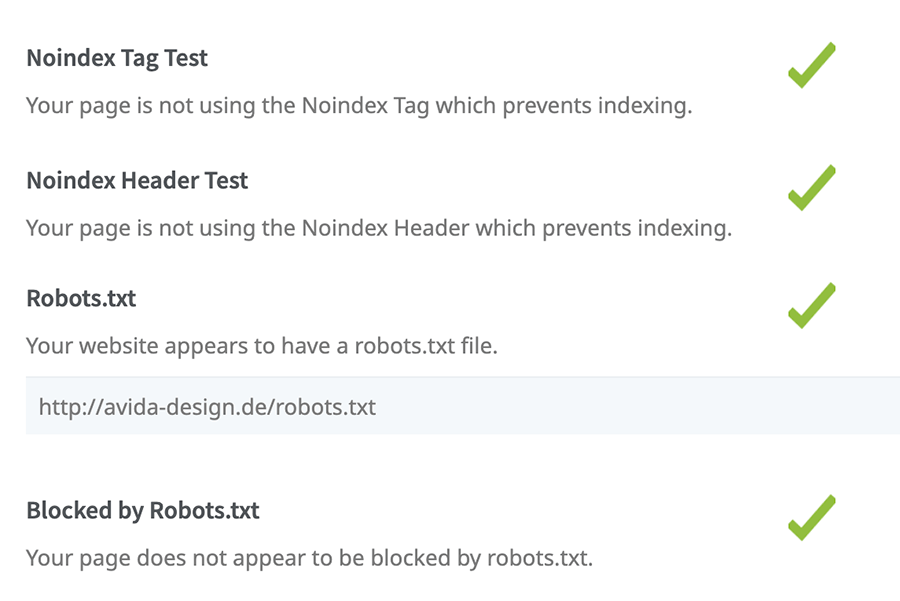

Ergebnis Seoptimer

Du kannst bei SEOptimer.com ↑ kostenfrei ein kleines Website-Audit machen. SEOptimimer erkennt keinerlei Blockierungen durch Tags – ganz anders als die Google Search Console ↓ weiter unten in diesem Artikel.

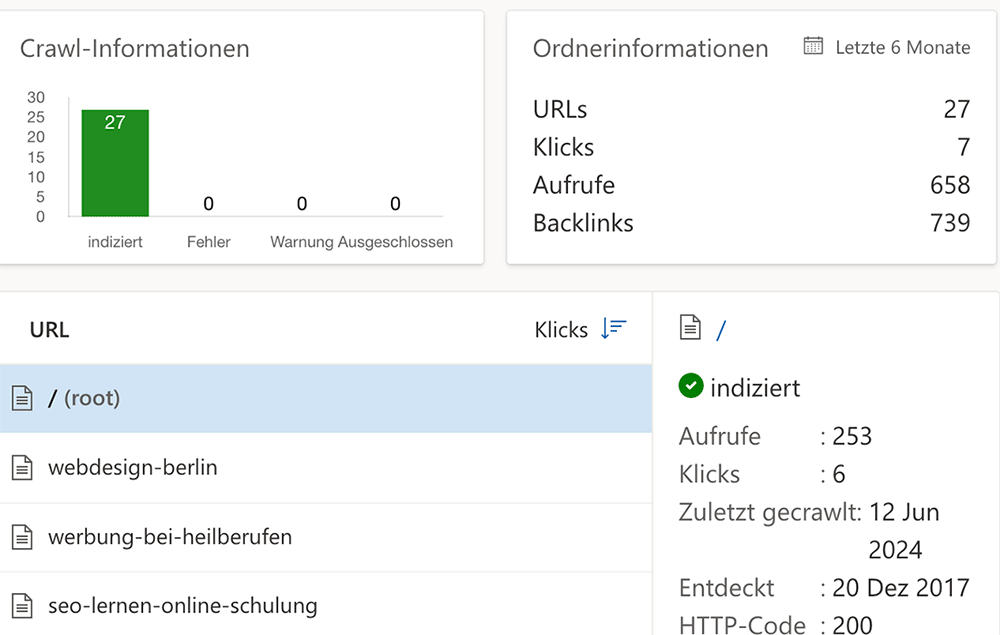

Ergebnis Bing

Bing hat von derselben Website 27 indexiert. Hier siehst du eine Übersicht – auch mit den am meisten bei Bing gefundenen Ergebnissen:

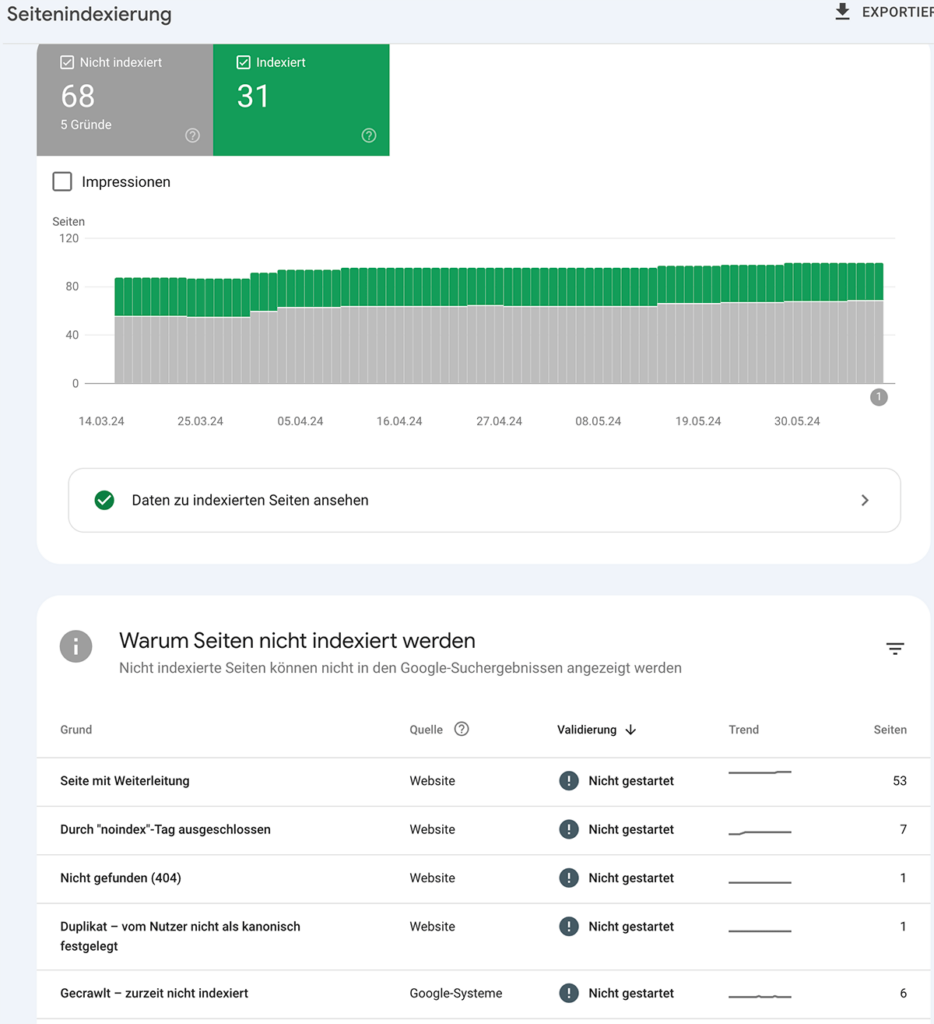

Ergebnisse der Google Search Console

Du kannst dies mit dem URL-Inspektionstool in der Google Search Console → überprüfen. Vorher sollte deine Website mit den Webmastertools der Google Search Console verknüpft sein →

Wenn du auf die Punkte klickst kommst du zu weiteren Erkenntnissen.

Erklärung der Indexierungsprobleme

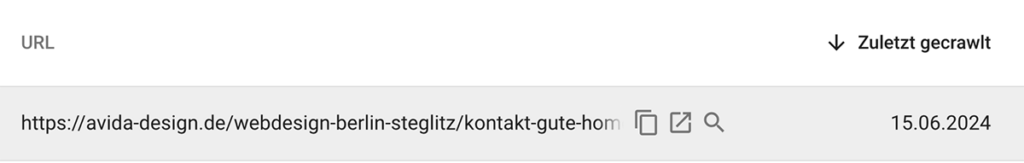

Seiten mit Weiterleitung

Bei der obigen Webpräsenz wurden bei einem Relaunch die alten URL auf die neuen suchmaschinenfreundlich weitergeleitet.

Wenn du auf die Lupe klickst, kommst du auf die Erklärung von Google warum und wieso diese Seite nicht in der Datenbank bei Google ist – hier voll beabsichtigt.

Hier gehst du alle Seiten durch und kannst danach handeln, indem du herausfindest, warum die Seite nicht indiziert wurde oder du ignorierst den Hinweis.

Warum zeigt die Search Console weiterhin die weitergeleiteten Seiten an?

Warum zeigt die Google Search Console bei der Seitenindexierung immer noch Seiten an, die mit einem 301-Redirect weitergeleitet wurden? Verschwinden diese nicht irgendwann aus der Google-Datenbank?

Die Google Search Console kann weiterhin Seiten anzeigen, die mit einem 301-Redirect weitergeleitet wurden, weil der Prozess, bis diese Seiten komplett aus dem Index verschwinden, einige Zeit in Anspruch nehmen kann. Hier sind einige Gründe, warum diese Seiten möglicherweise noch angezeigt werden:

- Indexierungs- und Aktualisierungszyklen: Google benötigt Zeit, um den gesamten Index zu aktualisieren. Während dieses Prozesses können weitergeleitete Seiten vorübergehend noch im Index verbleiben.

- Verweise und Backlinks: Wenn es viele externe Links zu der weitergeleiteten Seite gibt, kann Google sie länger im Index behalten, um sicherzustellen, dass die Link-Weitergabe korrekt gehandhabt wird.

- Crawler-Frequenz: Wenn Google-Bots deine Seite nicht sehr häufig crawlen, kann es länger dauern, bis die Änderungen vollständig erkannt und umgesetzt werden.

- Cache und Datenbanken Google speichert eine Menge Daten in verschiedenen Caches und Datenbanken. Diese müssen ebenfalls aktualisiert werden, was Zeit braucht.

Normalerweise verschwinden weitergeleitete Seiten nach einer Weile aus dem Index, aber dieser Prozess kann variieren. Um sicherzustellen, dass der Vorgang reibungslos abläuft, kannst du Folgendes tun:

- 301-Weiterleitungen korrekt einrichten: Stelle sicher, dass deine 301-Weiterleitungen korrekt und konsistent eingerichtet sind.

- Sitemap aktualisieren: Reiche eine aktualisierte Sitemap ohne die weitergeleiteten URLs ein.

- Google Search Console benachrichtigen: Nutze die Option „Indexierung anfordern“ in der Google Search Console, um den Prozess zu beschleunigen.

- Backlinks aktualisieren: Versuche, so viele externe Links wie möglich direkt auf die neuen URLs zu aktualisieren.

Diese Schritte können dazu beitragen, den Prozess zu beschleunigen und sicherzustellen, dass die alten URLs schneller aus dem Index verschwinden.

Indexierung durch noindex nicht möglich

Hier will Google die Sitemaps nicht indizieren und behauptet stur, es gäbe einen noindex-Tag. Die Sitemap ist mit Rank-Math erstellt und sieht für mich unauffällig aus.

Teste ich hier doch mal Bing. Bing Webmastertools findet nur eine Seite, die nicht indexiert wird, und das zur Recht – die Login-Seite.

Auch mit dem XML-Sitemap-Validator →, habe ich keine Probleme erkannt.

Lösung: ich lasse es an der Stelle ruhen und schaue nächsten Monat nochmal nach.

404-Monitor

Ein 404-Fehler bedeutet, dass die angeforderte Seite auf dem Server nicht gefunden wurde. Das kann passieren, wenn die URL falsch eingegeben wurde oder die Seite gelöscht bzw. verschoben wurde. Das schaue dir genau an und leite die Seite ggf. weiter an die richtige Adresse. Nutze hier die 301-Weiterleitung.

404 zu 301

Eine 301-Weiterleitung ist eine dauerhafte Umleitung von einer URL zu einer anderen. Sie teilt Suchmaschinen und Browsern mit, dass die angeforderte Seite dauerhaft verschoben wurde und automatisch zur neuen URL weitergeleitet werden soll.

Duplikat – nicht als kanonisch festgelegt

Auch hier genau prüfen, welche Seite / Datei gemeint ist. In diesem Fall waren es 2 gleiche PDF-Dateien, von denen eine dann gelöscht wurde und die alte URL dieser Datei dann auf die neue weitergeleitet wurde.

Was ist eine kanonische URL?

Eine kanonische URL ist die bevorzugte Version einer Webseite für Suchmaschinen wie Google.

Sie signalisiert der Suchmaschine, welche URL die Hauptversion des Inhalts ist, auch wenn es mehrere Versionen der Seite mit leicht unterschiedlichen URLs gibt. Damit kannst du doppelten Content vermeiden, z.B. werden bei einem Shops & CMS doppelte Seiten gebildet und bilden immer denselben Inhalt ab

shop.de/Schuhe/turnschuh-nike-groesse-41.php

shop.de/Schuhe/page?12345

shop.de/Warenkorb/Schuhe/turnschuh-nike-groesse-41.php

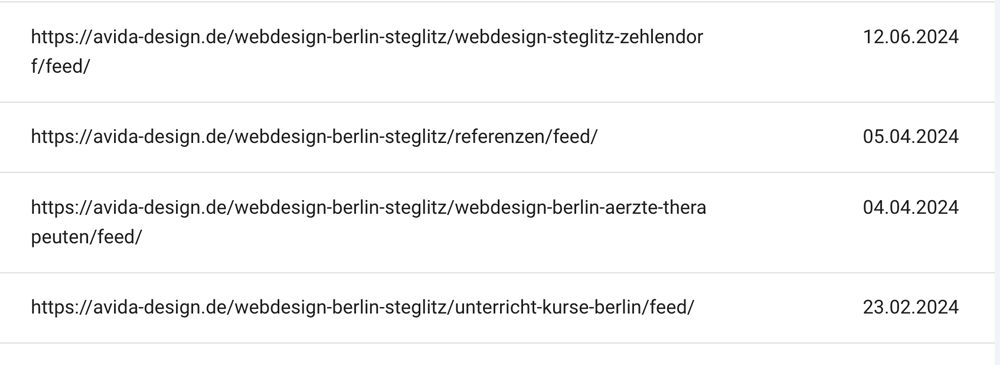

Gecrawlt – zurzeit nicht indexiert

Sind bei dieser Website Feeds, die bei WordPress-Kategorien automatisch gebildet werden.

Willst du diese (WordPress-)Feeds loswerden, dann füge deiner functions.php in deinem Childtheme → folgenden Code hinzu:

function itsme_disable_feed() {

wp_die( __( 'No feed available, please visit the <a href="'. esc_url( home_url( '/' ) ) .'">homepage</a>!' ) );

}

add_action('do_feed', 'itsme_disable_feed', 1);

add_action('do_feed_rdf', 'itsme_disable_feed', 1);

add_action('do_feed_rss', 'itsme_disable_feed', 1);

add_action('do_feed_rss2', 'itsme_disable_feed', 1);

add_action('do_feed_atom', 'itsme_disable_feed', 1);

add_action('do_feed_rss2_comments', 'itsme_disable_feed', 1);

add_action('do_feed_atom_comments', 'itsme_disable_feed', 1);Fazit

Mein Fazit zu dieser Recherche:

- Mich um Duplikate und 404-Fehler kümmern

- Hinweis auf noindex-Tag ignorieren – habe Quelltext und die robots.txt → geprüft, mir die Website bei Ubersuggest angeschaut und alles für gut befunden.

- Gecraweled, nicht indexiert – hier die Feedtechnik deaktivieren

- Interessantes Fundstück: Bei Bing stehen andere Inhalte im Vordergrund als bei Google – hier noch mal schauen, ggf. jeweils die am meisten gefundenen Seiten noch mal überarbeiten.

Du siehst, es macht Sinn, die Indexierung im Blick zu behalten. Und mach dich nicht verrückt – wenn du soweit gekommen bist, hier einen Blick unter die Haube zu werfen, bist du weit mit deinem SEO und deinem technischen Verständnis.