Aktualisiert am 18. Juni 2024

Dieser Artikel ist gehört zu der SEO-Checkliste für das SEO-Audit →

Denk daran, beim Erstellen oder Bearbeiten deiner Website eine robots.txt-Datei hinzuzufügen. Diese kleine Textdatei informiert die Robots der Suchmaschinen darüber, welche Teile deiner Website sie crawlen und indizieren dürfen.

Robots sind kleine Programme, die das Internet durchsuchen und Webseiten für Suchmaschinen finden und speichern. So gibt es z.B. Googlebots oder Bingbots, die Robots von Google und Bing.

Vorteile der robots.txt-Datei

Du kannst übrigens jedes Textprogramm nehmen und die Datei als .txt abspeichern.

- Verbesserung der Ladezeit deiner Website, indem unwichtige Seiten vom Laden ausgeschlossen werden.

- Verhindert, dass Suchmaschinen doppelte Inhalte auf deiner Website indizieren.

- Schützt deine Website davor, dass spammige oder minderwertige Seiten indiziert werden.

- Fokussiert deine SEO-Bemühungen auf die wichtigsten Seiten deiner Website.

Hat die Website eine Robots.txt ?

Das findest du ganz einfach heraus, indem du hinter Domain robots.txt schreibst: https://digitalfahrschule.de/robots.txt →

Hier siehst du ein paar Beispiele für robots.txt-Dateien – nicht zu verwechseln mit dem Meta-Tag robots →

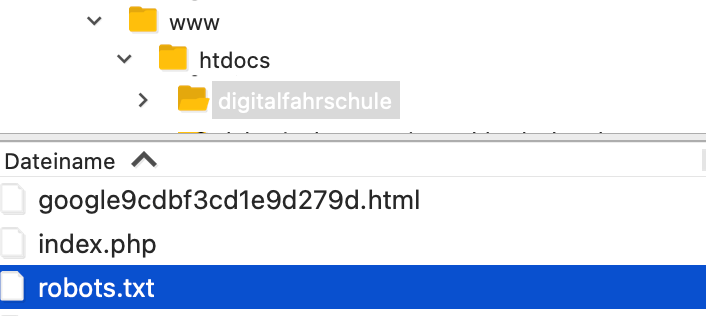

Wo muss diese Datei hin?

Ins Rootverzeichnis deine Website. Über FTP oder den Webspace deines Providers lädst du die Datei hoch.

Beispiele

Erlauben, verbieten, informieren

User-agent: Googlebot Disallow: /images/ Sitemap: https://digitalfahrschule.de/sitemap.xml

Das bedeutet, dass der User-Agent namens „Googlebot“ den Ordner digitalfahrschule.de/images/ samt Unterverzeichnissen nicht crawlen soll. Gleichzeitig wird auf die XML-Sitemap hingewiesen.

Alles erlauben

User-agent: * Allow: /

Hier wird nichts verboten, sondern alles erlaubt. Manche Provider stellen dir eine robots.txt zur Verfügung, die so aussieht – inhaltlich überflüssig, da die Bots ohnehin alles crawlen, wenn ihnen nichts ausdrücklich verboten wird.

Mehrere Sitemaps

User-agent: * Allow: / Sitemap: https://domain.de/sitemap_index.xml Sitemap: https://domain.de/post-sitemap.xml Sitemap: https://domain.de/page-sitemap.xml Sitemap: https://domain.de/tribe_events-sitemap.xml

Wenn du mehrere Sitemaps hast, wie z.B. Seiten, Beiträge und Veranstaltungen.

Beispiel einer ausführlichen robots.txt mit Erläuterung

User-agent: * Disallow: /pfad/zu/verbotenem/verzeichnis/ Allow: /pfad/zu/erlaubtem/verzeichnis/ Sitemap: https://www.deinewebsite.de/sitemap.xml User-agent: Googlebot Allow: /images/ Disallow: /admin/ User-agent: Bingbot Disallow: /geschuetzter/bereich/

Erläuterung

- User-agent: Diese Zeile gibt an, für welchen Webcrawler die Anweisungen gelten. Im ersten Fall (*) gelten die Anweisungen für alle Crawler. In den folgenden Zeilen werden Anweisungen für bestimmte Crawler definiert, z. B. Googlebot und Bingbot.

- Disallow: Diese Zeile verbietet dem Crawler den Zugriff auf den angegebenen Pfad und alle Unterverzeichnisse. In unserem Beispiel ist der Zugriff auf das Verzeichnis /pfad/zu/verbotenem/verzeichnis/ für alle Crawler verboten.

- Allow: Diese Zeile erlaubt dem Crawler den Zugriff auf den angegebenen Pfad und alle Unterverzeichnisse. In unserem Beispiel ist der Zugriff auf das Verzeichnis /pfad/zu/erlaubtem/verzeichnis/ für alle Crawler erlaubt.

- Sitemap: Diese Zeile gibt die URL der Sitemap-Datei deiner Website an. Die Sitemap-Datei enthält eine Liste aller URLs deiner Website, die von Suchmaschinen indexiert werden sollen.

- Weitere User-Agent-Regeln: Du kannst weitere User-Agent-Regeln hinzufügen, um den Zugriff auf bestimmte Bereiche deiner Website zu steuern. In diesem Beispiel ist der Zugriff auf das Verzeichnis /images/ für den Googlebot erlaubt, während der Zugriff auf das Verzeichnis /admin/ für den Bingbot verboten ist.

Gut zu wissen

- Die robots.txt-Datei ist eine Textdatei und darf keine HTML-Tags oder anderen Code enthalten.

- Syntaxfehler in der robots.txt-Datei können dazu führen, dass Suchmaschinen deine Website nicht richtig crawlen können.

1 Gedanke zu „SEO-Audit Checkliste 4 – Robots.txt erstellen und einreichen“